논문 리뷰) Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

https://arxiv.org/abs/2303.04137

Diffusion Policy: Visuomotor Policy Learning via Action Diffusion

This paper introduces Diffusion Policy, a new way of generating robot behavior by representing a robot's visuomotor policy as a conditional denoising diffusion process. We benchmark Diffusion Policy across 12 different tasks from 4 different robot manipula

arxiv.org

0. Abstract

- Diffusion Policy 도입

이 논문은 로봇의 Visuomotor Policy를 Conditional denoising diffusion process로 표현하여 로봇의 행동을 생성하는 새로운 방법 Diffusion Policy를 소개한다. 이러한 DIffusion Policy는 Action-distribution score function의 Gradient를 학습하며, 추론 시에 Gradient field를 따라 Langevin Dynamics 단계를 수행하며 최적화를 반복적으로 진행한다.

cf. Visuomotor Policy: 시각 입력에 기반하여 로봇의 행동을 결정하는 정책

- Result 요약

4개의 로봇 조작 벤치마크에서 15개의 다양한 작업에 대해 평가, 기존 SOTA 모델들보다 평균 46.9% 더 우수한 성능을 지속적으로 보임을 확인했다. 또한 Multimodal Distribution을 잘 처리하고, High-dimensional Action Space에 적합하며, 뛰어난 학습 안정성을 확인했다.

cf1. Multimodal Distribution: 여러 개의 가능한 행동이 존재하는 확률 분포.

cf2. High-dimensional Action Space: 차원이 많은 행동 벡터 공간

- Key technical contributions

실제 로봇 Visuomotor policy 학습에 Diffusion Model의 잠재력을 최대한 활용하기 위해 다음 핵심 기술적 기여들 제안한다.

1) Receding Horizon Control: 일정 시간 범위만 예측하여 반복적으로 계획을 갱신하는 제어 방식

2) Visual Conditioning: 시각 정보를 기반으로 모델의 출력을 조건화하는 방식.

3) Time-series Diffusion Transformer: 시계열 데이터에 확산 모델을 적용하기 위한 트랜스포머 구조

1. Introduction

- Policy Learning: 기존 연구들과 Diffusion Policy

인간 또는 다른 에이전트의 Demostration를 기반으로 한 Policy learning은 가장 단순하게는 관찰값을 행동들로 맵핑하도록 학습하는 Supervised regression Task로 볼 수 있다. 하지만 로봇 행동 예측의 고유한 특성으로 인해 실제로는 일반적인 지도학습보다 더욱 복잡하고 도전적이다.

로봇 행동 예측 고유 특성

1) Multimodal distributions: 하나의 관찰에 대해 여러 개의 가능한 행동이 존재하는 분포

2) Sequential correlation: 시간에 따른 행동 간의 연속성 존재

3) High precision 요구: 작은 오차도 큰 결과 차이를 만드는 정밀 제어이기 때문에

기존 연구들은 이 복잡한 Task를 해결하기 위해 행동 표현 방식을 다양하게 바꾸는 시도들을 해왔다. Gaussian 혼합 모델를 사용하거나, 양자화된 Categorical 표현을 사용하거나, 행동을 직접 출력하지 않고 간접적으로 행동을 정의하는 Implicit Policy를 사용하여 Multi-modal distributions를 더 잘 표현하는 등의 방법들이 있었다.

해당 연구에서는 로봇의 행동 공간에 대해 Conditional Denoising Diffusion Process를 적용하는 새로운 Diffusion Policy를 제안한다. 행동을 직접 출력하지 않고, 시각 관찰을 조건으로 한 행동 스코어 함수의 그래디언트를 예측하고, 이를 기반으로 K번에 걸쳐 denoising을 수행하며 점진적으로 정답에 가까운 행동을 생성한다.

- Diffusion Policy 세 가지 핵심 장점

1) 다중모드 행동 분포 Multimodal action distributions를 효과적으로 표현할 수 있음

> 행동 스코어 함수의 Gradient를 학습하고, 이 Gradient field에서 Langevin Dynamics 샘플링을 수행하면서 Multimodal distribution을 포함한 정규화 가능한 임의의 분포를 표현할 수 있게 된다.

2) 고차원 출력 공간 High-dimensional output space 을 다룰 수 있음

> Diffusion Model은 고차원 출력 공간에 매우 잘 확장됨. 이를 통해 단일 행동이 아닌 행동 시퀀스 전체 추론 가능.

>> Temporal action consistency를 유지하고, Myopic planning를 피하는 데 매우 중요함.

cf1. Temporal action consistency: 시간에 따른 행동의 연속성과 일관성. ex) 왼쪽으로 돌기 시작했으면 계속 왼쪽으로 돌아야함

cf2. Myopic planning: 짧은 시야만 보고 의사결정을 내리는 방식. 전체 목표를 고려하지 못함

3) 학습 안정성 Stable training이 뛰어남

> 에너지 함수의 그래디언트만을 학습함으로써 이러한 문제를 회피하고, 표현력을 유지하면서도 안정적인 학습 가능

- Primary contribution # 세 가지 장점을 로봇 로보틱스 분야에 도입

1) Closed-loop action sequences

> 고차원 행동 시퀀스를 예측하는 Diffusion Policy의 능력 + Receding-Horizon Control을 결합

>> Close-Loop 방식으로 지속적으로 행동 재계획, Temporal action consistency 유지, 장기 계획과 즉각적인 반응의 균형 달성

cf1. Receding Horizon Control: 일정 시간 범위만 예측하여 반복적으로 계획을 갱신하는 제어 방식

cf2. 시퀀스를 한 번에 예측할 수 있는 디퓨전 모델로 일부분을 예측하고 이후 피드백을 받아 재계획한다는 것이다.

2) Visual conditioning

> 시각 관찰을 조건부에 도입한 Vision-conditioned diffusion policy 도입

>> 시각 표현을 한 번만 추출하면 되기에 계산량이 대폭 줄어들고, 실시간 추론 가능

3) Time-series diffusion transformer

> CNN 기반 모델은 시계열 예측에서 출력을 너무 over-smoothing, 트랜스포머 기반의 새로운 확산 네트워크를 제안

>> 고빈도 행동 변화와 속도 제어가 필요한 작업에서 SOTA 성능 달성

세 가지 장점을 로봇 분야에 도입하려는 세 가지 기술적 기여로 Diffusion Policy는 행동 모방 Behavior cloning 설정으로 4개의 서로 다른 벤치마크에서 15개의 작업에 대해 성능이 일관되게 향상되었으며, 평균 46.9%의 향상을 보여 Diffusion Policy의 효과를 강하게 입증함.

2. Diffusion Policy Formulation

로봇의 Visuomotor policy를 Denoising Diffusion Probabilistic Model((DDPM))을 통해 구현하게 되며, 이를 통해 복잡한 다중모드 행동 분포를 표현할 수 있고, 안정적인 학습이 가능하며, 과도한 과제별 하이퍼파라미터 튜닝 없이도 잘 작동하게 된다.

DDPM의 세부 구조와 이를 Visuomotor policy에 적용하기 위해 어떻게 적용하는지 알아볼 것이다.

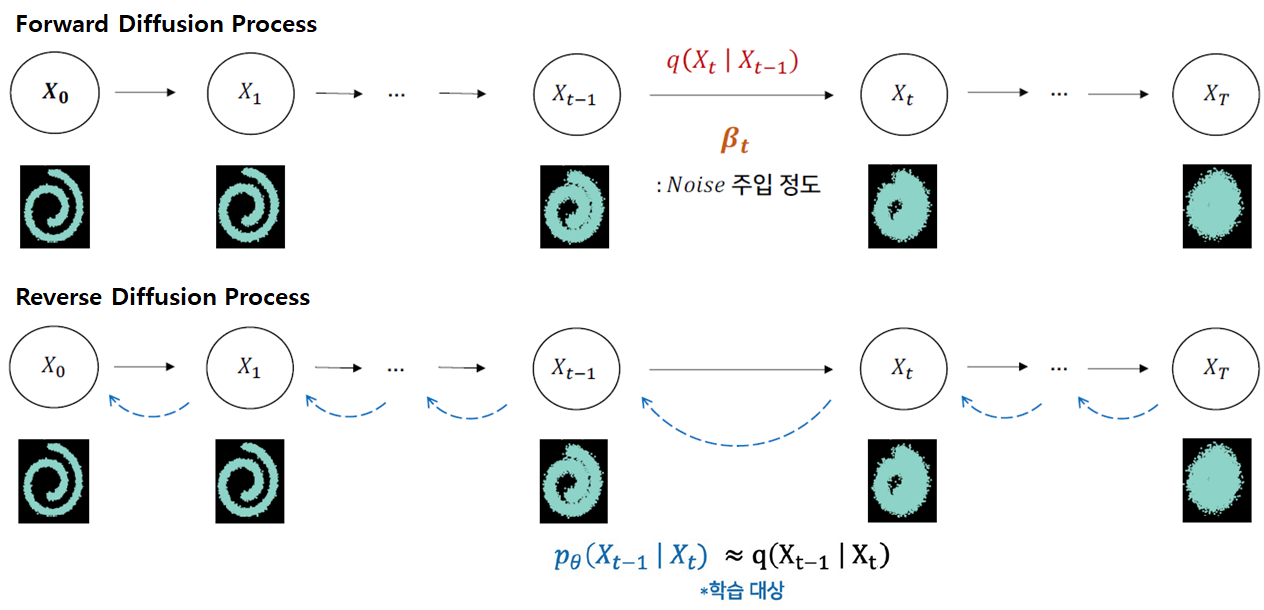

- Denoising Diffusion Probabilistic Models ((2.1))

DDPM은 노이즈 제거 과정을 모델링하는 생성형 모델의 한 종류이며, 이 과정은 Stochastic Langevin Dynamics라고 부른다. 가우시안 노이즈에서 샘플링한 (X_k)부터 시작하여, K 단계의 디노이징을 수행, 결과 마지막 깨끗한 출력 (X_0)를 출력하게 된다.

εθ: Step 정보와 현재 노이즈 상태에서 노이즈가 얼마나 껴 있는지 예측하는 뉴럴 네트워크. 학습을 통해 최적화됨.

γ: 얼마나 디노이징할 지 결정하는 상수

N: 매 반복마다 추가되는 가우시안 노이즈

α: 스케일링 계수, 를 1보다 약간 작게 설정하면 학습 안정성이 향상된다는 것이 실험적으로 확인되어있다.

-> α,γ,σ 를 반복 스텝 k에 따라 변화시키는 것을 noise schedule이라고 한다. 이는 러닝레이트 스케줄링처럼 해석될 수 있다.

해당 식을 단일 noisy gradient descent step으로도 해석하면 다음과 같이 표현할 수 있다.

- DDPM Training ((2.2))

DDPM 학습 과정을 요약한 파트이다.

1) 학습 과정은 깨끗한 원본 샘플 (X_0)을 무작위로 선택하는 것에서 시작

2) 이후 각 샘플마다 denoising 단계 k를 무작위로 선택하고, 해당 단계에 적합한 분산을 갖는 εk를 샘플링한다.

-> 노이즈 예측 네트워크는 노이즈가 추가된 데이터 샘플에서 그 노이즈를 예측하도록 학습된다.

해당 Loss를 사용하면 샘플링된 데이터의 분포 p(x0)와 디노이징 스탭을 거쳐 만들어진 결과의 분포 q(x0) 사이의 KL Divergence에 대한 ELBO를 최소화하는 것과 같다. 이는 DDPM에서 증명하였다.

- Diffusion for Visuomotor Policy Learning ((2.3))

DDPM을 이미지 생성이 아닌, Robot visuomotor policy 학습에 사용하기 위해 수식 구조를 변경이 필요하다.

1) 출력 X를 로봇의 Action으로 수정

-> 이미지 생성이 아니고, 로봇의 행동을 만들어야 하므로 당연

2) Denoising 과정을 입력된 observation (

- Closed-loop action-sequence prediction # 장기 계획과 즉각적인 반응의 균형 달성 # 4.3 에서 더 자세히

효과적인 Action formulation은 long-horizon planning의 시간적 일관성과 Smoothness를 유지하면서도, 예상하지 못한 관찰에 빠르게 반응할 수 있어야 한다.

해당 목표를 달성하기 위해, 확산 모델이 예측한 행동 시퀀스를 일정 시간 동안 고정 실행하고, 그 후 재계획을 수행하게 된다.

-> 시퀀스를 한 번에 예측한 이후, 그 중 일부는 실제로 사용하고 나머지는 무시하고 새로 예측하여 유연성을 확보.

1) 시간 t에서, Diffusion Policy는 관찰값 (O_t)를 입력으로 받아 (T_p)개의 행동 시퀀스을 예측함

2) (T_p)길이의 행동 시퀀스 중에서 (T_a) 개의 행동은 재계획 없이 그대로 실행 # 장기 계획

3) 일정 시간이 지나면 다시 새로운 시퀀스를 예측하여 계획을 갱신 # 예측하지 못한 관찰값에 대한 즉각적인 반응

-> 이전에 예측한 시퀀스이 있기에 연결성 Smoothness 유지 가능

: Observation Horizon 관찰 시야 길이

: Prediction Horizon 행동 예측 길이

: Action Execution Horizon 재계획 없이 실행할 행동 수

- Visual observation conditioning

기존 연구들은 관찰과 행동을 같은 입력 공간에서 다루며 joint distribution p((At ,Ot))으로 표현했지만, 해당 연구에서는 conditional distribution

기존 구조 p((At ,Ot))는 미래의 환경 상태까지 함께 예측하므로 계산량이 컸다.

이와 달리 관찰값을 조건부로 보내면 미래 상태 추론 비용 없이 관찰을 조건으로 행동을 예측할 수 있게되며, 확산 과정이 빨라지고, 생성된 행동의 정확도가 향상되며, 비전 인코더와의 E2E 학습이 가능해진다.